หนึ่งใน Top Strategic Technology Trends ของ Gartnerในปี 2022 คือ Data Fabric หลายๆคนอาจจะเข้าใจว่าเป็นการสร้างสถาปัตยกรรม Big Data อย่าง Data Warehouse, Data Lake หรือ Data LakeHouse หรือเป็นการทำ Single source of Truth ที่จะให้นักวิเคราะห์ข้อมูลสามารถเข้าใช้ได้จากแหล่งเดียวกัน ซึ่งจริงๆแล้วอาจไม่ใช่คำตอบที่ถูกต้องนัก

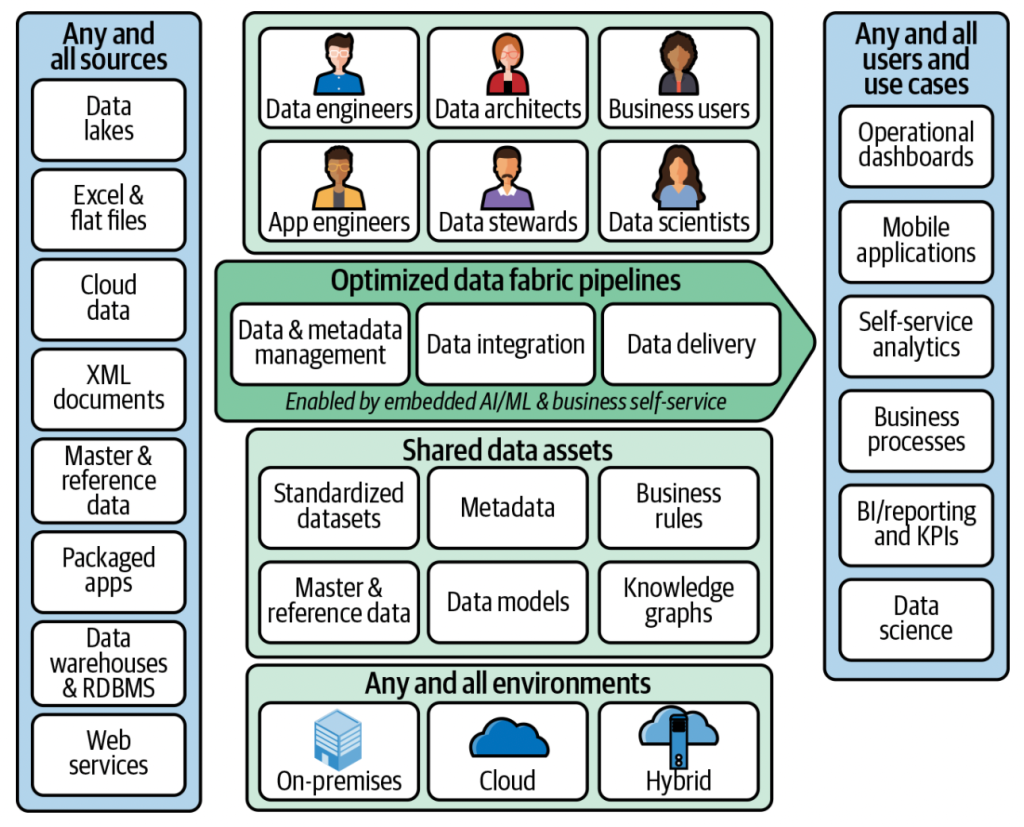

ผมได้อ่านรายงานเรื่อง Data Fabric as Modern Data Architecture ของ Alice LaPlante ที่ได้อธิบายในเรื่องนี้ไว้ว่า หลักการของ Data Fabric เป็นการทำ Data Architecture แบบกระจายในรูปแบบใหม่ (Modern Distributed Data Architecture) ที่จะทำให้เราสามารถจะเข้าถึงข้อมูลที่แชร์ไว้และสามารถบริหารจัดการข้อมูลเหล่านั้นได้ โดย Data Fabric จะมีหลักการสำคัญสามเรื่องคือ

- การมีข้อมูลสำหรับผู้ใช้ทุกคนและทุกกรณี กล่าวคือจัดเตรียมข้อมูลที่น่าเชื่อถือและทันสมัยกับการวิเคราะห์ที่หลากหลาย การบริหารและจัดการธรรมาภิบาลวิเคราะห์ รวมถึงการให้ผู้ใช้ทางธุรกิจ (Business user) สามารถใช้งานได้ด้วยตนเอง

- การมีข้อมูลทั้งหมดจากหลายแหล่ง กล่าวคือจะต้องมีข้อมูลทั้งที่เก็บไว้ในแหล่งเก็บข้อมูล หรือข้อมูลที่เคลื่อนไหว จากหลายแหล่ง โดยข้อมูลอาจมีรูปแบบที่แตกต่างกัน แต่จุดสำคัญคือต้องมีข้อมูลให้ครบถ้วนทั้งหมด

- การมีข้อมูลที่อยู่ในระบบใดๆที่หลากหลาย กล่าวคืออาจมีทั้ง Data Warehouse, Data Lake หรือ Data LakeHouse ในหลายๆระบบ แต่ละระบบอาจอยู่ทั้งบน On-Premise หรือ Multi Cloud ก็ได้ ไม่จำเป็นต้องมีรวบรวมไว้ที่เดียว

ดังนั้นจะเห็นได้ว่าหลักการของ Data Fabric ไม่ใช่หมายถึงการจะมาทำ Data Lake หรือ Data Lakehouse ชุดเดียว และไม่สามารถจะทำได้โดยใช้ Product ใดๆเพียงรายเดียว แต่อาจเป็นการบริหารจัดการสถาปัตยกรรม Big Data ที่มีอยู่ให้ตอบโจทย์ที่เป็นหลักการของ Data Fabric ให้ได้ โดย Data Fabric จะมีองค์ประกอบดังนี้

- Data Catalog ที่ให้เราสามารถที่จะมีแคตตาล็อกของของข้อมูล จากแหล่งข้อมูลที่หลากหลาย เพื่อให้บริหารจัดการและทำธรรมาภิบาลข้อมูลได้ดีขึ้น

- Master data management กล่าวคือมี Master data ชุดหนึ่งสำหรับข้อมูลทั้งภายในและภายนอกองค์กร

- Metadata management กล่าวคือมีนโยบายในการจัดการข้อมูลเพื่อให้มั่นใจได้ว่า สามารถเข้าถึง แชร์ เชื่อมโยง วิเคราะห์ และดูแลรักษาได้

- Data preparation มีเครื่องมือหรือซอฟต์แวร์ที่จะทำ Data Cleansing เพื่อให้องค์กรมั่นใจได้ว่าจะข้อมูลที่ทีคุณภาพ และมีความถูกต้อง

- Data Integration มีกระบวนการที่จะทำให้ข้อมูลจากหลายแหล่วสามารถเชื่อมโยงกันได้ และทำให้ผู้ใช้สามารถเห็นได้อย่าง Single View

- Data Analytics มีกระบวนการที่สามารถนำข้อมูลจากหลายแหล่งมาวิเคราะห์ได้

- Data Visualisation มีเครื่องมือที่จะเห็นข้อมูลจากหลายแหล่งในรูปแบบของกราฟหรือการแสดงผลที่ดูได้อย่างเข้าใจง่าย

- Data Governance มีนโนบายเพื่อให้แน่ใจได้ว่าข้อมูลต่างๆมีคุณภาพ และสามารถเข้าถึงได้จากกลุ่มผู้ใช้ต่างๆ

การสร้างสถาปัตยกรรม Data Fabric จึงไม่ได้หมายถึงการจัดกหา Product ตัวใดตัวหนึ่ง หรือจะเกิดขึ้นได้ทันทีทันใด แต่ Data Fabric จะใช้ระยะเวลาในการเดินทาง (Journey) ขึ้นไปตามลำดับ จนบรรลุเป้าหมาย ในหนังสือของ Alice LaPlante ได้ระบุว่าการทำ สถาปัตยกรรม Data Fabric จะมี Data Pipeline อยู่ 5 ขั้นคือ

ขั้นตอนที่ 1 Collect: คือการเก็บข้อมูล ซึ่งอาจเป็นแบบ Real time เช่นข้อมูลจาก Transactional Database ข้อมูลจาก IoT ข้อมูลจากการบริการลูกค้า

ขั้นตอนที่ 2 Extract & Load: คือการดึงข้อมูลที่เก็บจากขั้นตอนที่ 1 โหลดลงไปใน Database หรือ Storage ในการเก็บข้อมูล ขั้นตอนนี้อาจต้องมีการทำ ETL หรือ ELT และในขั้นตอนนี้จะมีการทำ Data Preperation เพื่อให้ได้ข้อมูลที่มีคุณภาพ

ขั้นตอนที่ 3 Store: คือการเก็บข้อมูลที่อาจอยู่ใน Data Warehouse, Data Lake หรือ Data Lakeshore ข้อมูลที่เก็บในขั้นตอนนี้จะรวมไปถึง Streaming Data

ขั้นตอนที่ 4 Transform & Optimize: ขั้นตอนนี้สำคัญเป็นขั้นตอนที่สำคัญสุดของ Data Fabric จะเป็นการบริหารจัดการข้อมูล การทำ Master Data management (MDM) และการบริหารจัดการ Metadata ของข้อมูล

ขั้นตอนที่ 5 Delivery: ขั้นตอนนี้คือการส่งต่อให้ผู้ใช้ สามารถที่จะนำข้อมูลไปค้นหา วิเคราะห์ หรือแสดงผลได้ โดยผู้ใช้อาจต้องสามารถเข้าถึงข้อมูลได้ตามสิทธิ์และมี Data Catalog ให้ผู้ใช้

ซึ่งขั้นตอนเหล่านี้สามารถแสดงได้ตามรูปที่ 1

กล่าวโดยสรุปสถาปัตยกรรม Data Fabric จะประกอบด้วยเครื่องมือที่หลากหลาย และเป็นหลักแนวคิดที่มีขั้นตอนในการทำงานมากกว่าที่จะเป็นการลงทุนกับ Product หรือระบบใดระบบหนึ่ง

ธนชาติ นุ่มนนท์

IMC Institute

บทความอื่นๆที่เกี่ยวข้อง

- ตอนที่ 1 : Big Data Pipeline ทำไมไม่ใช่ Data Warehouse

- ตอนที่ 2 : สถาปัตยกรรมบน Data Lake

- ตอนที่ 3 : จาก Hadoop แบบ On-Premise สู่การใช้บริการบน Public cloud

- ตอนที่ 4 : สถาปัตยกรรม Data platform บน Public cloud

- ตอนที่ 5 : สถาปัตยกรรม Data platform สำหรับประมวลผลข้อมูลแบบ Streaming

- ตอนที่ 6 : สถาปัตยกรรม Cloud Data platform สำหรับประมวลผลข้อมูลทั้งแบบ Batch และ Streaming

- ตอนที่ 7: แนวโน้มสถาปัตยกรรม Big Data 2022

- ตอนที่ 8: การจัดการข้อมูลบน Data Lake

- ตอนที่ 9: สถาปัตยกรรม Data Lake + Data Warehouse

- ตอนที่ 10: สถาปัตยกรรม Data Lakehouse